【ICLR '18】Variational Image Compression with a Scale Hyperprior

Info

Title: Variational Image Compression

with a Scale Hyperprior

Author: Johannes

Balle

Pub: ICLR 2018

Keyword:

Hyperprior

Motivation

- 已有研究(例如Ballel2017的工作)还是用的变换+量化的形式来压缩。然而这些方法在量化时往往忽略了图像中的空间依赖性,导致压缩性能并非最优。

- 传统压缩方法钟,边缘信息的结构是手动设计的。

Method

引入超先验有效捕捉潜在表示中的空间依赖关系:潜在表示 y 量化为 ŷ,然后建立一个新的模型去学习ŷ中的依赖关系,以消除y中的冗余信息。这里有两个问题需要思考一下:

为什么要对经过量化的 ŷ = Q(y) 建模,而不是直接对潜在表示 y 进行建模,以学习依赖关系? 我认为主要原因是:量化后的ŷ是离散值,通过熵编码实现无损压缩。熵编码的压缩效果取决于模型对 ŷ 的分布的准确估计,而不是对 y。未经量化的 y 虽然包含图像全部信息,但并不最终用于编码传输,且连续值不适合进行熵编码。

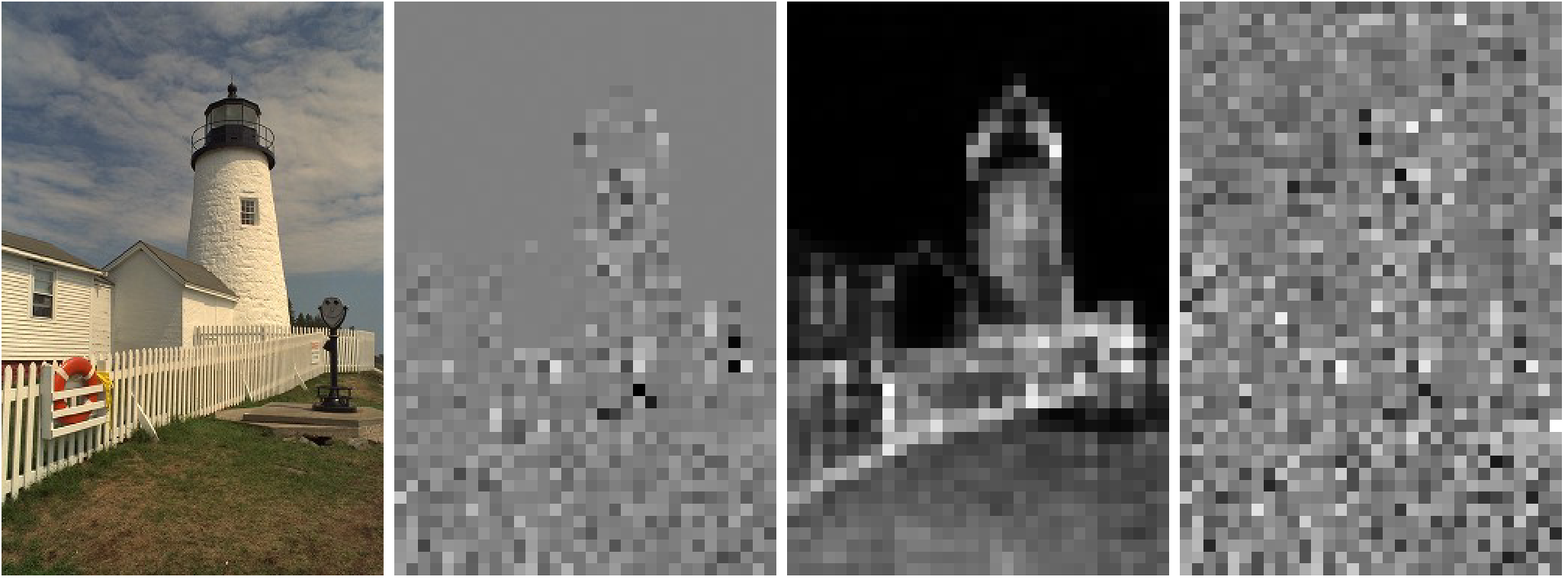

为什么要消除 y 中的轮廓信息? 先看一下论文中的图:

很明显可以看出,潜在表示y仍然可以看出原图的轮廓,这表示还存在冗余结构信息。为什么说冗余呢,以一维的等差数列 {x, x + 1, x + 2, ..., x + n} 为例,要压缩这串数列,我们只需要保存 (x, n),即可重构整个数列。而在图像中y也一样,某个像素块也与周围色素快存在依赖关系,即可以互相转化,因此说这种轮廓是冗余的结构信息。 ___

Experiment

训练:网络中100万张彩色图像。

测试:Kodak数据集,Tecnick数据集。

Discussion

简单分享一下自己的理解,欢迎指正。博主叶笙箫给出了更详细的解读和代码标注,见 >端到端的图像压缩—-《Joint Autoregressive and Hierarchical Priors for Learned Image Compression》 论文笔记

Note

联合分布 vs 边缘分布 vs 全分解分布(概率论基本知识)

1)联合分布(Joint Distribution):描述多个随机变量同时取不同值得概率分布,反应变量之间得整体关系。

2)边缘分布(Marginal Distribution):从联合分布中忽略部分变量,得到剩余变量的概率分布。比如两个随机变量X和Y,他们的联合分布是P(X, Y),那么X的边缘分布是通过对Y的所有可能值求和(离散型)或积分(连续型)得到。

3)全分解分布(Fully Factored Distribution):假设所有变量相互独立,联合分布可分解维各变量边缘分布的乘积。信息论的一些概念

1)香农熵/信息熵(Shannon Entropy):衡量随机变量的不确定性,表示编码该变量所需的平均最小比特数。定义为:H(P) = −∑xP(x)logP(x)

2)香浓交叉熵(Cross-Entropy):用预测分布Q编码真实分布P所需的平均比特数。定义为: H(P, Q) = −∑xP(x)logQ(x) 当 Q = P 时,交叉熵退化为香浓熵。传统压缩方法提高行能的方法之一是传输边缘信息:从编码器发送到解码器的附加信息,对熵模型进行修改以减少不匹配。这么设计是因为特定图像的边缘信息通常与模型设计的边缘信息相差很大。

KL散度代表两个分布之间的差异。