【ICLR '17】End-to-end optimized image compression

Info

Title: End-to-end optimized image

compression

Author: Johannes Balle

Pub: ICLR 2017

Repo: https://github.com/tensorflow/compression

Motivation

- 联合优化率(rate)和失真(distortion)是困难的,现有算法例如JPEG通常是线性变换、均匀量化和熵编码三步走。

- 采用线性变换无法有效捕捉图像的非线性特征(例如边缘、纹理等复杂结构),压缩后的图像容易出现视觉上的失真(伪影等)。

Method

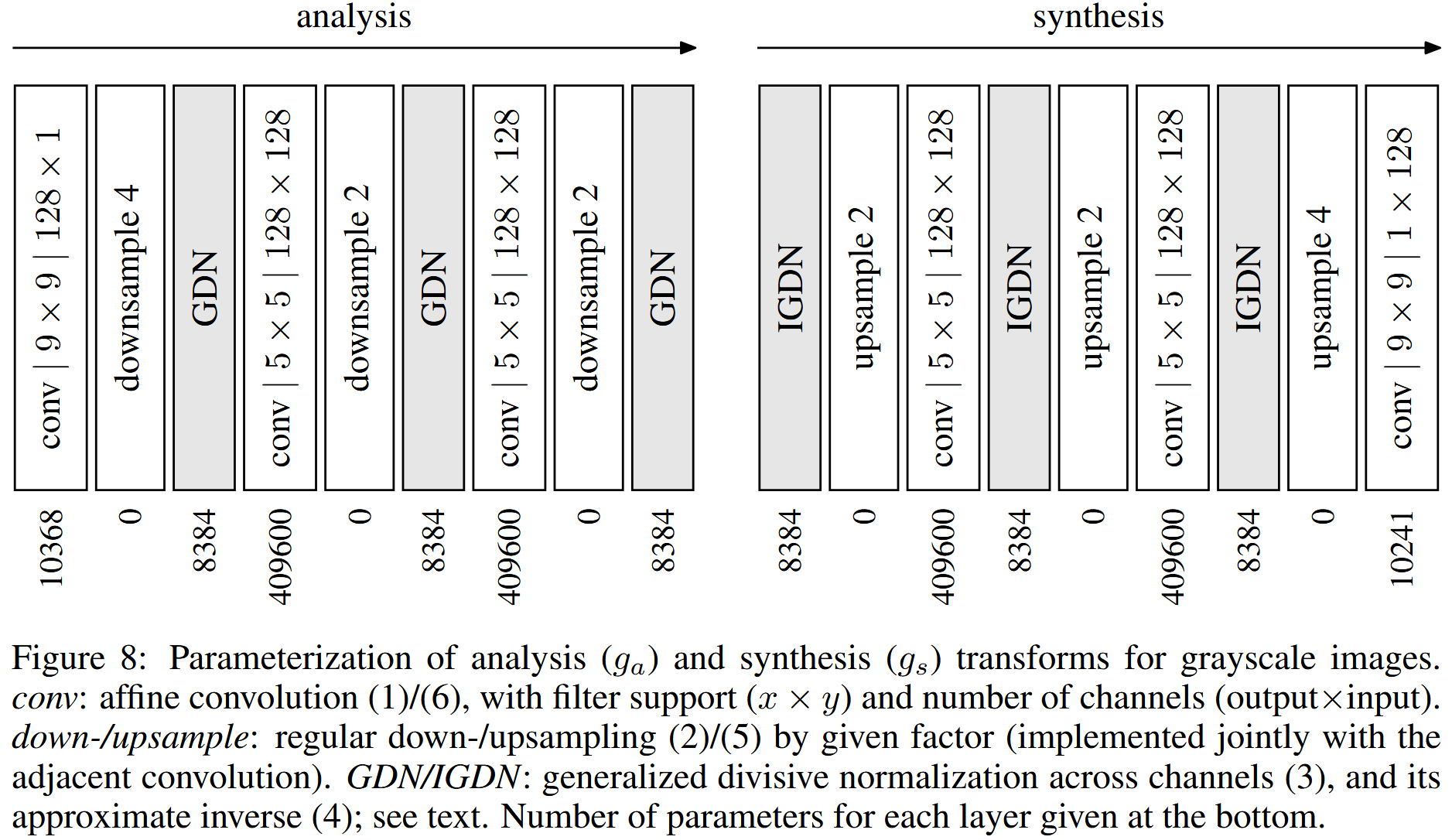

- 提出一个端到端压缩框架,包括非线性变换、均匀量化和熵编码,结构如上图所示。优化目标是L=R+λD,其中λ控制两项的平衡,即联合优化。【对应Motivation1】。

量化将连续值转换为有限的离散值集合,减少冗余信息的同时,也引入了失真。而量化函数的导数处处为零,优化不了一点儿。

因此作者提出用一种连续的概率模型来替代传统的量化操作,即通过添加独立同分布的均匀噪声来近似量化误差,由于是一种近似值,文中也说是relaxed。

最终的损失函数 L = R + λD 改写为了连续可导的:

L(θ, ϕ) = 𝔼x, Δy[−∑ilog2pỹi(ga(x; ϕ) + Δy; ψ(i)) + λd(gp(gs(ga(x; ϕ) + Δy; θ)), gp(x))]

最后直接使用随机梯度下降法优化。(PS:中间的证明过程我就不解释了,引用的都是之前论文的结论,我也没看过QAQ)

- 引入非线性变换,其实就是GDN标准化算法,实现一种局部增益控制形式。【对应Motivation2】 作者说是受到生物神经元模型的启发。标准化这块儿这里可以看看博主dongmie1999的文章: 【dongmie1999】END-TO-END OPTIMIZED IMAGE COMPRESSION 论文阅读笔记

Experiment

- Dataset: ImageNet的一个子集。

- Baselines: JPEG、JPEG 2000。

- Result: 在所有码率下,图像的视觉质量都有显著提升,主要是更自然了没有传统算法出现的伪影。

Discussion

大神的ICLR之作属实太稳了,刚入LIC领域,读得也是很困难,有太多先验知识了,继续学吧。

Note

- 码率(rate)和失真(distortion)存在平衡关系,追求低码率低失真。不同任务的平衡程度不同。

- 变换编码方法(如JEPG)包括三部分:变换(线性到非线性)、量化(去冗余)、熵编码(压缩)。

- 采用了GDN标准化,也常用于图像和信号处理。不同于BN、GN、LN等线性变换,GDN是非线性的。

- 码率-失真,使用了随机梯度下降法进行联合优化。

【ICLR '17】End-to-end optimized image compression

https://mahuidong.com/2025/03/25/End-to-end optimized image compression/